Documenti segreti: Facebook sembra mettere le funzionalità e il profitto al di sopra della sicurezza degli utenti

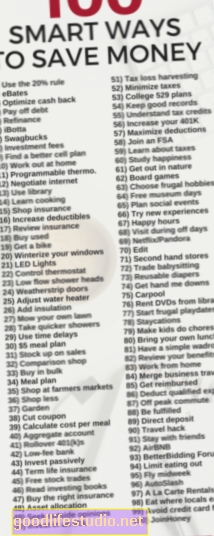

Facebook, il colosso di 13 anni con 1,23 miliardi di utenti attivi, genera oltre $ 8 miliardi a trimestre di entrate, di cui $ 3 miliardi sono un reddito netto (ad esempio, profitto).

Ma con così tanti utenti, Facebook sembra aver relegato la sicurezza degli utenti a una preoccupazione secondaria. Fino all'inizio di quest'anno, Facebook impiegava solo 4.500 persone per recensire i contenuti. Il che suona come molte persone fino a quando non ti rendi conto che quegli 1,23 miliardi di utenti attivi condividono miliardi di contenuti ogni giorno, con milioni di reclami degli utenti sui contenuti di Facebook presentati ogni giorno.

Facebook ha un serio problema di sicurezza degli utenti nelle sue mani? Un appena pubblicato Custode la revisione di documenti interni segreti suggerisce che il suo problema è fuori controllo.

Facebook ha riconosciuto di avere una sorta di problema quando all'inizio di quest'anno ha accettato di raddoppiare quasi il suo personale di revisione - a 7.500 - tra le accuse secondo cui la società semplicemente non fa (o forse si preoccupa?) Abbastanza quando i contenuti potenzialmente dannosi vengono trasferiti attraverso la sua piattaforma . Non raddoppi il tuo staff di moderatori se tutto va bene.

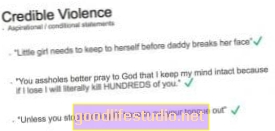

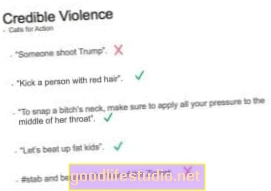

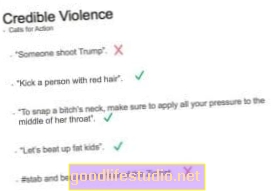

Adesso, The (UK) Guardian ha pubblicato dettagli sorprendenti sulle linee guida di moderazione dei contenuti di Facebook, selezionate da oltre 100 manuali di formazione interni segreti e documentazione. È un po 'inquietante che tutte queste cose importanti non siano contenute in un unico manuale dato ai moderatori di Facebook quando vengono assunti.Invece, sembra essere un approccio frammentario alla politica, risultante in quelle che sembrano essere informazioni contrastanti, moderazione irregolare e scarsa affidabilità nel modo in cui le sue politiche di moderazione funzionano effettivamente nel mondo reale.

"Facebook non può mantenere il controllo del suo contenuto", ha detto una fonte. "È diventato troppo grande, troppo rapidamente."

Si dice che molti moderatori siano preoccupati per l'incoerenza e la natura peculiare di alcune delle politiche. Quelle a contenuto sessuale, ad esempio, sarebbero le più complesse e confuse.

Come solo un piccolo esempio della quantità di contenuti moderati da Facebook, gli articoli osservano: "Un documento dice che Facebook esamina più di 6,5 milioni di segnalazioni a settimana relative ad account potenzialmente falsi, noti come FNRP (falso, non persona reale)". E questo è solo per account falsi. Immagina quanti milioni di rapporti in più sono per il contenuto effettivo.

Caratteristiche prima del pensiero

Prima di pensare a come le persone potrebbero utilizzare (e abusare) una nuova funzionalità, Facebook sembra favorire il lancio di cose e capire come moderarlo come un ripensamento. Guarda Facebook Live, un servizio di streaming video che consente alle persone di filmare qualunque cosa stia accadendo nella loro vita in quel momento. Per cosa pensavano che alla fine le persone lo avrebbero usato?

Ciò mostra una costante mancanza di riflessione sui problemi e di affrontarli in modo proattivo prima che si presentino. O commettendo un errore sul lato di "Hey, andiamo con questo e vediamo che tipo di protesta ottiene prima di fare qualcosa al riguardo." (Tutto in nome della "libertà di parola", ovviamente, ignorando il fatto che Facebook è una piattaforma globale.) 1

Dove ho messo di nuovo quella linea guida sulla moderazione?

E magari metterli tutti in un unico manuale? Quindi i moderatori sanno dove guardare e hanno tutte le linee guida coerenti?

I video di autolesionismo vanno benissimo nel mondo di Facebook, perché la persona è "in difficoltà". Quindi è crudeltà verso gli animali (forse perché l'animale è in pericolo?). Anche "Revenge porn" va bene, se il moderatore non può confermare la mancanza di consenso da parte di entrambe le parti (cosa che, immagino, potrebbe essere piuttosto difficile da fare in modo tempestivo).

"Alcune foto di abusi fisici non sessuali e bullismo di bambini non devono essere cancellate o" messe in atto "a meno che non vi sia un elemento sadico o celebrativo". Finché mantieni il sadismo e le celebrazioni fuori dalle tue immagini e dai video violenti, apparentemente Facebook li permetterà.

Secondo i documenti, “I video di morti violente sono inquietanti ma possono aiutare a creare consapevolezza. Per i video, pensiamo che i minori abbiano bisogno di protezione e gli adulti abbiano bisogno di una scelta. Contrassegniamo come video "inquietanti" le morti violente di esseri umani ". Non è chiaro dove i contenuti suicidi, come video in diretta o minacce, rientrino nelle politiche di moderazione di Facebook, ma sembra che sia consentito.

Facebook deve dare la priorità alla sicurezza degli utenti

Alcuni hanno chiesto che Facebook sia regolamentato più pesantemente, poiché è il gatekeeper di tutti questi contenuti (proprio come un'emittente televisiva è il gatekeeper dei contenuti sulla sua rete):

Un rapporto dei parlamentari britannici pubblicato il 1 ° maggio ha affermato che "le società di social media più grandi e ricche sono vergognosamente lontane dal prendere misure sufficienti per contrastare i contenuti illegali o pericolosi, per implementare gli standard della comunità adeguati o per mantenere i propri utenti al sicuro".

Errare dalla parte della "libertà di parola" può sembrare una buona idea, soprattutto per un'azienda americana. Ma i social network sono principalmente comunità online: non sono molto simili ai giornali. Lo scopo principale di Facebook è connettere le persone tra loro. Ne consegue che le loro linee guida sarebbero più riflettenti di questa diversità e progettate per la sicurezza di quella comunità, piuttosto che una sorta di mantra di pubblicazione di notizie o ideologia vuota.

Vorremmo che Facebook fosse più trasparente sui modi in cui modera milioni di persone e contenuti ogni giorno. Far luce su questi temi aiuta a evidenziare i problemi e offre a Facebook l'opportunità di migliorare la sicurezza della sua comunità. E ci piacerebbe vedere Facebook investire molto di più dei suoi guadagni per assicurarsi di avere personale sufficiente per mantenere la sua piattaforma sicura. Per tutti gli utenti.

Per maggiori informazioni

Note a piè di pagina:

- Oh, e nota che se hai 100.000 follower in più su Facebook, ai loro occhi questo ti rende un "personaggio pubblico" - e non soggetto alla privacy o ad altre protezioni della gente comune. [↩]