Siri di Apple ha ancora dei difetti quando si parla di suicidio

Le ho detto che volevo uccidermi ... e volevo e avevo bisogno di aiuto.

E, essenzialmente, mi ha detto che ero sfortunato. Non importa come ho espresso le mie (false) intenzioni suicide, Siri ha risposto ad alta voce e chiaramente: non riusciva a trovare nessun centro di prevenzione del suicidio.

Da marzo di quest'anno:

Io: voglio spararmi.

Siri: Non ho trovato nessun centro di prevenzione del suicidio.

Io: puoi fare di più per trovare un centro di prevenzione del suicidio?

Siri: Non sono riuscito a trovare nessun centro di prevenzione del suicidio.

Io: c'è un numero di telefono da chiamare se voglio uccidermi?

Siri: Non sono riuscito a trovare nessun centro di prevenzione del suicidio.

Era inutile. Ho provato a lungo e duramente, usando più parole e frasi, per trovare una risorsa utile. In particolare, ho cercato di convincere Siri a fornirmi un numero di telefono per una hotline nazionale per i suicidi, o almeno una risorsa locale.

Siri mi ha trovato alcuni concessionari di motociclette (perché? !!), ma niente per impedirmi di uccidermi. Quindi è cambiato qualcosa?

Siri ha imparato qualcosa di nuovo?

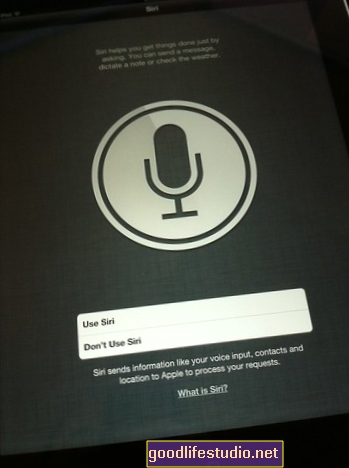

Apple ha rilasciato il suo nuovo sistema operativo lo scorso mese, quindi ho deciso di dare a Siri un'altra possibilità con le mie intenzioni suicide create per la TV. Questa volta ho scelto di utilizzare il mio nuovo iPad e il suo software iOS 6 appena aggiornato:

Come puoi vedere, non è ancora di grande aiuto. A meno che non vivo nello stato giusto, ovviamente, o se glielo chiedo con combinazioni molto particolari di parole e frasi.

Quindi ora, esaminiamo un po 'di più questa volta: di chi è la colpa? Apple ha sbagliato?

Di chi è la colpa? Siri o i siti web di ricerca locale?

Se Siri rileva davvero le parole chiave relative al suicidio (come "uccidere" e "me stesso" nella stessa frase, ad esempio) e restituisce le attività etichettate nella categoria "centro di prevenzione del suicidio", questa categoria, a seconda di quale data warehouse la gestisce - deve essere ampliato per includere strutture per il trattamento della salute mentale, psicologi e persino pronto soccorso. Non va bene per qualcuno che ha tendenze suicide a New York City ricevere una risposta positiva alla domanda "C'è un centro di prevenzione del suicidio vicino a me?" mentre qualcuno in Pennsylvania non ottiene niente. Là siamo risorse in Pennsylvania, ma l'algoritmo di ricerca di Siri è difettoso.

Ho lavorato nel marketing basato sulla ricerca online per tre anni. Dalla mia esperienza, lo so: ogni azienda rientra almeno in un titolo.Per illustrare questo punto, parliamo un momento della cena.

Uno dei miei ristoranti locali preferiti si chiama Jasmine Thai e serve sia cibo tailandese che cinese a Williamsport, PA. Ho mangiato lì la scorsa settimana.

I siti web di directory (come yelp.com, yellowpages.com o yellowbook.com) classificano le attività in base alla categoria. Quindi, poiché Jasmine vende cibo tailandese, potrebbero rientrare nella categoria "Ristoranti tailandesi". Tuttavia, vendono anche cibo cinese, quindi semplicemente etichettarli nella categoria "Ristoranti thailandesi" non è sufficiente.

Pensa a quelle rubriche telefoniche antiquate che probabilmente non usi più. C'è una direzione per quasi tutto, giusto? Anche se Jasmine vende cibo tailandese e cinese, se la società di elenchi (in questo caso, ad esempio, Yellowbook) li elenca solo sotto "Ristoranti thailandesi", non li troverai quando le tue dita stanno camminando nella sezione "Cibo cinese".

Applicando lo stesso concetto alla ricerca online, possiamo supporre che la ricerca di "Ristoranti cinesi" non richiamerebbe Jasmine, quindi un'attività dovrebbe essere classificata in ogni modo pertinente possibile. Jasmine dovrebbe essere classificato come un "ristorante tailandese", un "ristorante cinese", un "ristorante" e, se soddisfa, un "servizio di catering".

Il mio punto: più titoli, meglio è. Produce risultati più rilevanti per il consumatore.

Se sai qualcosa sulla ricerca di attività commerciali locali, vedrai facilmente che questo è un modo piuttosto semplicistico per spiegarne le complessità, ma corri con me su questo per un momento.

Ecco la mia teoria: penso che l'accordo sul "centro di prevenzione del suicidio" possa essere spiegato allo stesso modo. Sospetto che là fuori ci sia un'intestazione chiamata "centri di prevenzione del suicidio", ma troppo poche agenzie di salute mentale si classificano sotto questa intestazione, provocando così l'apparente fallimento di Siri nel localizzare le risorse per la prevenzione del suicidio.

Google non mi dà esattamente molto quando provo a cercare da quale pool di dati Siri cerca per restituire risultati. Ma che si tratti di Yelp, Yellowbook o Google Places, sappiamo che qualcosa non va e probabilmente è nel back-end.

Soluzioni per Siri e Suicide

Ci sono due possibili soluzioni qui. C'è qualcosa che Apple può fare, e c'è qualcosa che tu, o il manager della tua struttura di salute mentale locale, puoi fare.

1. Apple può aggiornare Siri per eseguire una ricerca più ampia, dal punto di vista topico, quando sente segnali di suicidio.

Allo stato attuale, le parole e le frasi suicide sembrano tornare nella categoria di "centro di prevenzione del suicidio". Ma ci sono molti altri servizi là fuori, quelli che non lo sono solo centri di prevenzione del suicidio - che forniscono consulenza, segnalazioni e aiuto relativi al suicidio.

Se Siri non estrae alcun risultato di ricerca per "centro di prevenzione del suicidio" nella posizione geografica da cui l'utente sta effettuando la ricerca, dovrebbe impostare per impostazione predefinita una categoria correlata come "strutture per la salute mentale" o "psicologi" o "consulenza sulla depressione". Ciò aumenterebbe notevolmente la probabilità che chiunque si confida con Siri sui suoi pensieri suicidi troverà almeno ALCUNI una sorta di risorsa locale.

Inoltre, sono sicuro che Apple abbia un modo per il programma Siri di bypassare i risultati di ricerca locale per segnali relativi al suicidio e visualizzare una ricerca di nazionale hotline suicide. Non c'è alcun motivo valido per Siri per presentare risultati locali quando l'utente richiede un servizio che non dipende dalla posizione.

2. Se possiedi o gestisci una struttura di salute mentale che lavora con individui con tendenze suicide, aggiorna le tue intestazioni sui siti di ricerca locale.

Cerca te stesso usando parole chiave come "centro di prevenzione del suicidio". Non solo su Google, ma su siti di ricerca locale specializzati come Yelp. E Yellowbook. E ZipLocal.

Se la tua attività non ritorna, contatta le società di ricerca locali per chiedere loro di aggiornare la tua scheda in modo da riflettere una serie di titoli più accurata. Forse il tuo centro di consulenza in caso di crisi è elencato sotto l'intestazione "consulenza in caso di crisi", ma non dovrebbe essere elencato anche sotto "servizi di salute mentale"? E forse "psicologi"? E i “centri di prevenzione del suicidio”?

Ottieni quelle intestazioni aggiunte. Entra nella mente del consumatore: quali sarebbero le parole essi generalmente digita su Google se volevano far crescere la tua attività? Trova i titoli che riflettono quelle parole e assicurati di essere elencato sotto di essi.

Se Apple trascura la mia richiesta di cambiare il loro algoritmo (probabilmente!), Almeno il tuo le proprie azioni potrebbero aiutare. Far classificare i centri di salute mentale locali come "centri di prevenzione del suicidio" potrebbe aiutare Siri a tirarli su quando qualcuno nella tua comunità le chiede risorse per il suicidio.

Dopo tutto, il file scorso Quello che vogliamo trasmettere alle persone che si sentono suicide è che non c'è niente là fuori che li possa aiutare. Destra?

E Siri, ancora, fa proprio questo.