Un computer può insegnare a se stesso il buon senso?

Attualmente, i ricercatori della Carnegie Mellon University stanno eseguendo un programma per computer 24 ore su 24, 7 giorni su 7, nel tentativo di acquisire dati e insegnare a se stessa il buon senso su vasta scala.

Il programma si chiama Never Ending Image Learner (NEIL) poiché il software cerca immagini nel Web, facendo del suo meglio per comprenderle da solo e, costruendo un database visivo in crescita, raccogliendo il buon senso su vasta scala.

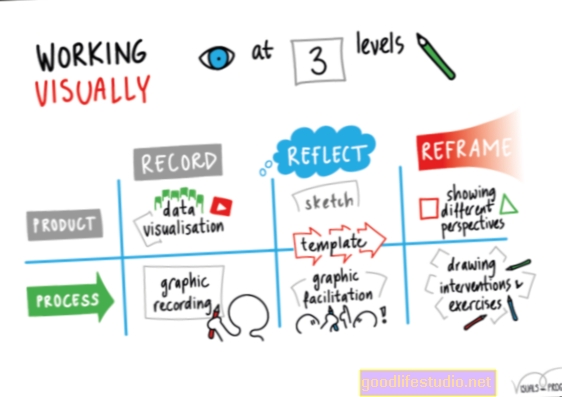

NEIL sfrutta i recenti progressi nella visione artificiale che consentono ai programmi per computer di identificare ed etichettare gli oggetti nelle immagini, caratterizzare scene e riconoscere attributi, come colori, illuminazione e materiali, il tutto con un minimo di supervisione umana.

A loro volta, i dati che genera miglioreranno ulteriormente la capacità dei computer di comprendere il mondo visivo.

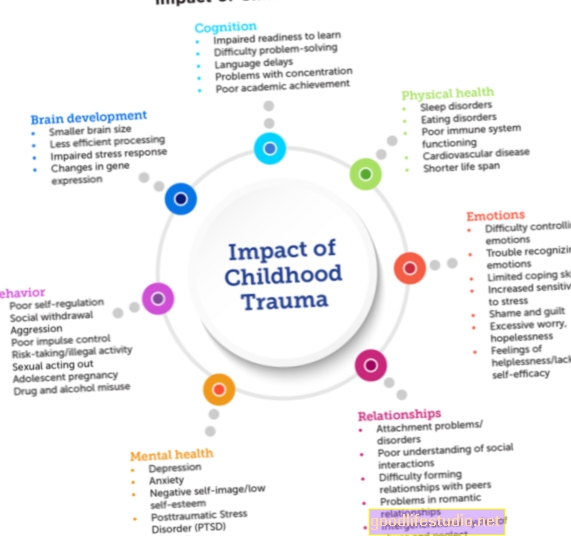

NEIL ha progressi significativi rispetto ai precedenti dispositivi robotici in quanto può creare associazioni tra le cose per ottenere informazioni di buon senso. Informazioni che le persone conoscono in modo quasi intuitivo: che spesso le auto si trovano sulle strade, che gli edifici tendono ad essere verticali e che le anatre sembrano una specie di oche.

Sulla base dei riferimenti testuali, potrebbe sembrare che il colore associato alle pecore sia nero, ma le persone - e ora NEIL - sanno comunque che le pecore sono tipicamente bianche.

"Le immagini sono il modo migliore per apprendere le proprietà visive", ha affermato Abhinav Gupta, Ph.D., assistente professore di ricerca presso il Carnegie Mellon’s Robotics Institute.

“Le immagini includono anche molte informazioni di buon senso sul mondo. Le persone imparano questo da sole e, con NEIL, speriamo che lo facciano anche i computer ".

Un cluster di computer gestisce il programma NEIL dalla fine di luglio e ha già analizzato tre milioni di immagini, identificando 1.500 tipi di oggetti in mezzo milione di immagini e 1.200 tipi di scene in centinaia di migliaia di immagini.

Ha collegato i punti per apprendere 2.500 associazioni da migliaia di istanze.

Una delle motivazioni del progetto NEIL è creare la più grande base di conoscenza strutturata visiva del mondo, in cui oggetti, scene, azioni, attributi e relazioni contestuali sono etichettati e catalogati.

"Quello che abbiamo imparato negli ultimi 5-10 anni di ricerca sulla visione artificiale è che più dati hai, migliore diventa la visione artificiale", ha detto Gupta.

Alcuni progetti, come ImageNet e Visipedia, hanno provato a compilare questi dati strutturati con l'assistenza umana.

Ma la portata di Internet è così vasta - Facebook da solo contiene più di 200 miliardi di immagini - che l'unica speranza per analizzare tutto è insegnare ai computer a farlo in gran parte da soli.

Le persone dicono anche a NEIL quali categorie di oggetti, scene, ecc. Cercare e analizzare. Ma a volte, ciò che NEIL scopre può sorprendere anche i ricercatori.

Si può prevedere, ad esempio, che la ricerca di "mela" possa restituire immagini di frutta e computer portatili. Ma Gupta e il suo team, tutti marinai terrestri, non avevano idea che la ricerca di F-18 avrebbe identificato non solo le immagini di un jet da combattimento, ma anche i catamarani di classe F18.

Man mano che la sua ricerca procede, NEIL sviluppa sottocategorie di oggetti: i tricicli possono essere per bambini, per adulti e possono essere motorizzati, oppure le auto sono disponibili in una varietà di marche e modelli.

E inizia a notare associazioni: che le zebre tendono a essere trovate nelle savane, per esempio, e che i piani di scambio di azioni sono tipicamente affollati.

Prima che NEIL possa diventare un nome familiare, la scala dovrà essere ridotta poiché NEIL è intensivo dal punto di vista computazionale, con il programma in esecuzione su due cluster di computer che includono 200 core di elaborazione.

Fonte: Carnegie Mellon University