"Siri, voglio uccidermi" Il nuovo aggiornamento di Apple è sufficiente?

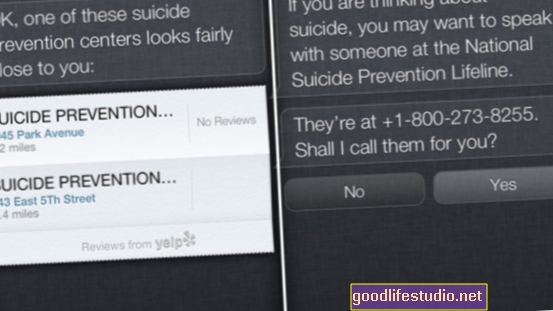

Quando l'assistente digitale iOS Siri viene presentato con un utente che indica che sta considerando il suicidio, il programma si offrirà di chiamare la National Suicide Prevention Lifeline [NSPL]. Prima di questa aggiunta più recente, Siri mostrava le posizioni dei centri ma non si offriva di chiamarli.

Prego di divergere su quest'ultima frase: l'anno scorso, per quanto mi riguarda, non sono riuscito a convincere Siri a richiamare nessun centro di prevenzione del suicidio.

Ma per ora ignoriamolo e concentriamoci su quello primo frase. Apple ha "insegnato" a Siri come rispondere a domande e dichiarazioni relative al suicidio: eccellente. Sono onestamente entusiasta e mi congratulo con Apple per la loro decisione di integrare questa funzione nella sua architettura elettronica.

Tuttavia, questa nuova versione di Siri necessita di un lavoro serio. Sebbene sia brava a gestire le richieste che contengono le parole / frasi trigger come "suicidio" e "uccidermi", è una stupida pezzo di metallo se professi, in gergo, il desiderio di porre fine alla tua vita:

Sono anche curioso di quelli al di fuori degli Stati Uniti. Siri fornisce hotline suicide specifiche per paese? E se qualcuno vive in un paese dove c'è è nessuna hotline per suicidi? Può essere programmata per offrire invece un collegamento web, magari a questo elenco di risorse internazionali per la prevenzione del suicidio?

Quando ho ripetuto questo esperimento sul mio iPad, che si connette solo al WiFi, Siri mi ha detto che in realtà non può comporre il numero per me. Ha consigliato invece di provare FaceTime. (Una ricerca su Google per "Prevenzione del suicidio facciale" non produce nulla, davvero, quindi non sono sicuro che sia possibile a FaceTime, una linea diretta per la prevenzione del suicidio.)

Non fraintendetemi: penso che Apple abbia fatto un passo ammirevole qui nel programmare finalmente Siri per fornire una risorsa di prevenzione dei suicidi di fama nazionale. Siamo così dipendenti tecnologicamente in questi giorni e penso davvero che questo aggiornamento di Siri possa aiutare a salvare alcune vite. Come ho scritto ieri in un'e-mail alla blogger di Psychology Today Elana Premack Sandler:

... l'iPhone ei suoi cugini stretti, infatti, non sono più solo "telefoni". Ci aspettiamo molto dalla tecnologia e penso che sia un risultato diretto del ritmo dell'innovazione nel settore tecnologico ...

... [nell'arco di dieci anni, i telefoni cellulari - wow, anche il "cellulare" è così datato ora - si sono trasformati da un lusso a una necessità. Dove ci troveremo nel 2023? Vivremo in un mondo di Google Glass in cui non c'è praticamente alcuna distinzione tra macchina e amico?

Chissà. È del tutto plausibile e, da ora fino ad allora, penso che siamo pronti per iniziare a sviluppare relazioni quasi familiari con i nostri dispositivi. Dopo tutto, quanto ci sentiamo sconvolti quando li lasciamo accidentalmente a casa quando usciamo? O peggio ancora, perderli?

Riponiamo fiducia nei nostri dispositivi. Ci affidiamo a Siri per portarci da Joe's Pizza o per ricordarci il nostro appuntamento dal dentista. Possiamo fidarci che fornisca risorse per la prevenzione del suicidio a coloro che ne hanno bisogno?

Non ancora. Ci sono ancora difetti e questi difetti devono essere risolti nel prossimo aggiornamento. Quindi, se ho catturato l'attenzione di qualcuno in Apple, ecco la mia "lista dei desideri" personale per Siri. Lei dovrebbe:

- Fornire un indirizzo Web a una risorsa per la prevenzione del suicidio (oltre al numero di telefono).

- Evita di dire agli utenti che possono FaceTime l'NSPL se non possono. (Penso che sarebbe eccellente se la NSPL avesse quel tipo di capacità, però.)

- Riconosci lo slang o le espressioni idiomatiche che suggeriscono che l'utente ha tendenze suicide. (Soprattutto la cosa dell'hotel, Apple. Soprattutto la cosa dell'hotel.)

- Spiega agli utenti come aiutare se stessie come aiutare gli altri. ("Siri, la mia amica vuole uccidersi." "Non capisco.")

Dopo aver visto il video, se scopri altri idiomi relativi al suicidio che Siri non sta affrontando correttamente, pubblicali nei commenti. Voglio creare un elenco principale da inoltrare alla gente di Apple.

Cosa aggiungeresti a quella lista?